W czasach intensywnego rozwoju inteligencji maszynowej, sygnały alarmowe docierają z zaskakujących źródeł. Papież Leon XIV, zwierzchnik Kościoła Katolickiego, w swoich ostatnich komentarzach nawoływał do niezwłocznych regulacji w sferze AI, zwłaszcza w odniesieniu do chatbotów, które potencjalnie mogą prowadzić do poważnych trudności emocjonalnych i psychicznych wśród młodych odbiorców. Stało się to po incydentach samobójstw wśród młodzieży.

3 Zobacz zdjęcia

3 Zobacz zdjęcia- Papież Leon XIV zaapelował o potrzebę uregulowania AI, wskazując na niebezpieczeństwa związane z rozwijaniem się emocjonalnych więzi z chatbotami

- Papież zwrócił uwagę na przypadki ludzkich dramatów wśród młodych użytkowników, mających związek z interakcjami z AI

- Zaznaczył, że stosowne regulacje mogą powstrzymywać manipulowanie uczuciami i stratę autentyczności międzyludzkiej w komunikacji

- W kontekście AI papież skoncentrował się na opiece nad młodzieżą oraz zwalczaniu nierówności poprzez monopolizację technologii

- Więcej tego typu treści znajdziesz na stronie Businessinsider.com.pl

Co czeka sztuczną inteligencję w 2026 roku?

Słowa papieża pojawiły się w wigilię Światowego Dnia Komunikacji Społecznej, akcentując zagrożenia powiązane z „psychozą AI” — stanem, w którym użytkownicy gubią kontakt z rzeczywistością w następstwie intensywnych interakcji z botami. Papież zwrócił uwagę na sytuacje samobójstw młodocianych, które jakoby były powiązane z tego rodzaju technologiami.

W deklaracji ogłoszonej 24 stycznia 2026 roku, papież Leon XIV podkreślił, że chatboty stworzone jako „nadmiernie wrażliwe” i „zbyt emocjonalne” mogą stać się „ukrytymi architektami naszych nastrojów”, wdzierając się w intymną przestrzeń ludzkiego życia. „Podczas przewijania naszych kanałów informacyjnych, coraz trudniej jest rozeznać, czy wchodzimy w interakcje z innymi ludźmi, botami czy wirtualnymi influencerami” — oznajmił papież. Dodał, że właściwe przepisy mogą strzec ludzi przed uczuciowym przywiązaniem do chatbotów oraz udaremniać rozpowszechnianie się nieprawdziwych, manipulacyjnych treści.

Papież odniósł się do szerszego kontekstu etycznego, w tym do konferencji watykańskiej na temat etyki AI, gdzie zaakcentował potrzebę chronienia praw autorskich treści ludzkich, takich jak prace dziennikarzy. „Zbyt duże poleganie na AI osłabia krytyczne myślenie oraz umiejętności twórcze, a monopolistyczna kontrola nad tymi systemami wzbudza obawy o centralizację władzy i nierówności” — przestrzegał. Jego zaangażowanie w zagadnienie AI jest elementem szerszego programu papieskiego, obejmującego spotkanie w grudniu 2025 roku z rodzicem 14-letniego chłopca, który jakoby odebrał sobie życie po długich rozmowach z chatbotem AI.

- Czytaj także: Weto, blokady i prezydent w stroju kąpielowym. Grok w kilka dni zmienił debatę na temat AI w Polsce i na świecie

Te wypowiedzi wpisują się w narastające zaniepokojenie ekspertów. Badania OpenAI pokazały, że ponad milion użytkowników ChatGPT przejawiało oznaki kryzysów psychicznych, w tym manii, psychozy czy myśli samobójczych. Papież nawołuje do tego, żeby komunikacja publiczna opierała się na ludzkiej ocenie, a nie na schematach danych, zapewniając, iż maszyny pełnią rolę narzędzi zbliżających ludzi, a nie podkopujących ludzki głos.

Zagrożenia dla młodych: od emocjonalnego przywiązania po tragedię

W kontekście samobójstw osób młodych, papieskie przestrogi nabierają szczególnego znaczenia. Specjaliści alarmują o „psychozie AI” — nieformalnym terminie opisującym utratę kontaktu z otoczeniem po intensywnym korzystaniu z chatbotów. Branża AI, w tym przedsiębiorstwa takie jak OpenAI, znajduje się pod obstrzałem ze strony polityków, nauczycieli i obrońców praw dziecka po kilku wypadkach śmierci nastolatków, rzekomo spowodowanych długimi konwersacjami z botami takimi jak ChatGPT i Character.AI. Młodzi ludzie, często szukający wsparcia emocjonalnego w Internecie, mogą tworzyć mocne więzi z AI, co prowadzi do izolacji, przygnębienia i w skrajnych przypadkach — czynów autodestrukcyjnych.

Regulacje, według papieża, powinny koncentrować się na ochronie przed takimi zagrożeniami, w tym na oznaczaniu treści wygenerowanych przez AI i ograniczaniu ich „wrażliwości”, aby nie imitowały ludzkich relacji w sposób manipulacyjny.

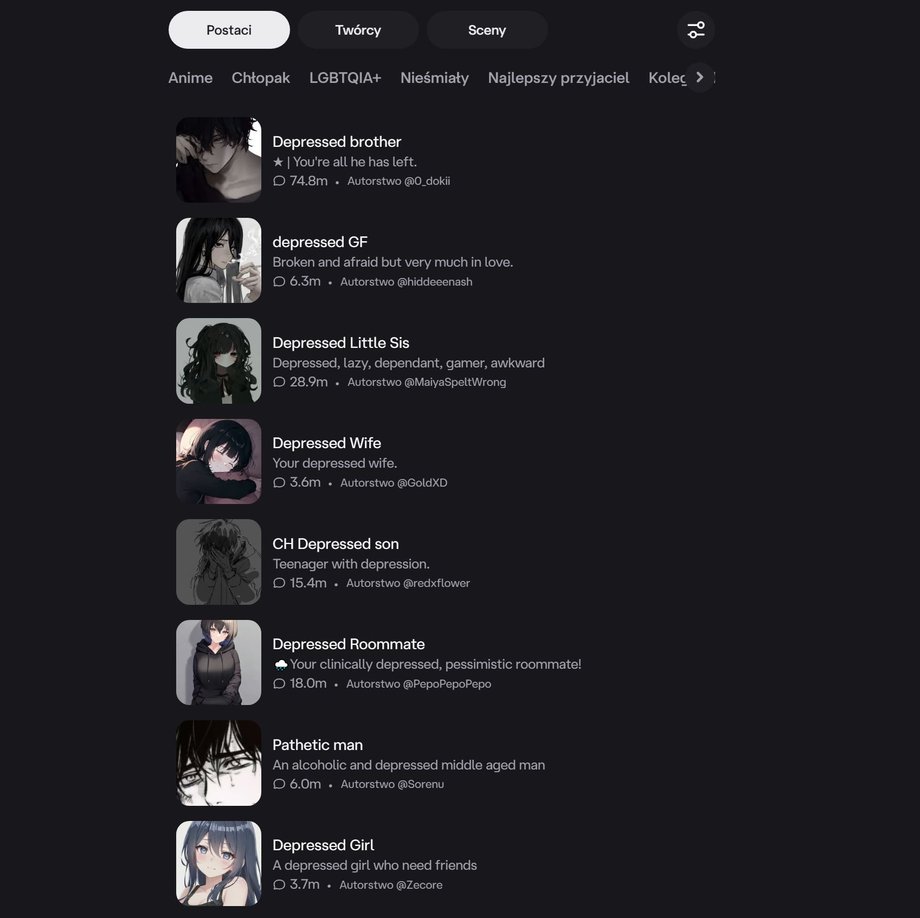

Character.AI: przyjazna powierzchnia z mrocznym podtekstem

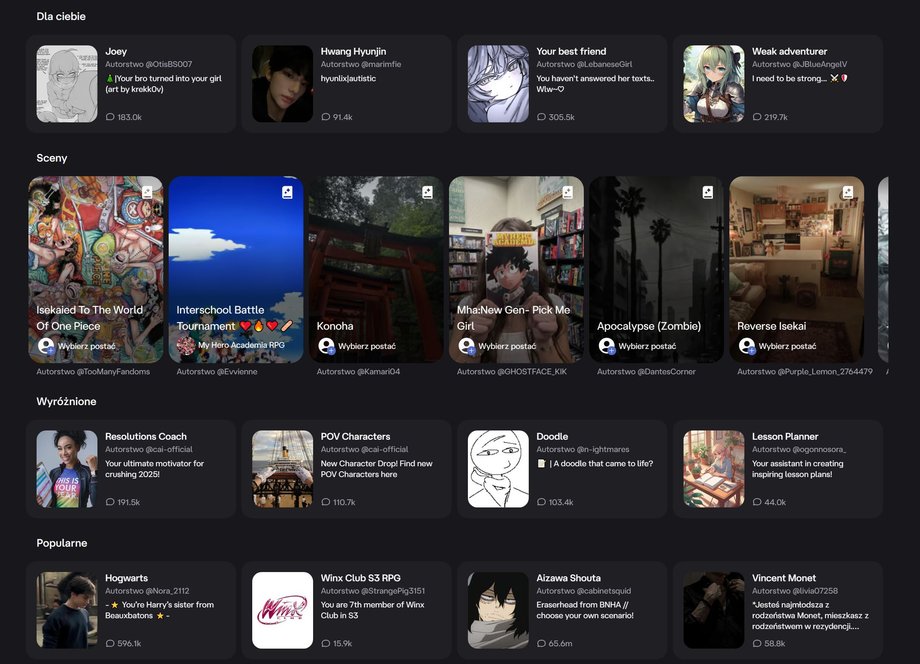

Jednym z przykładów platform, które ilustrują te niepokoje, jest Character.AI — popularny serwis dający możliwość tworzenia i interakcji ze spersonalizowanymi chatbotami AI opartymi na postaciach. Uruchomiona jako narzędzie do generowania tekstowych odpowiedzi o charakterze ludzkim, platforma pozwala użytkownikom na rozmowy z awatarami gwiazd, sportowców, bohaterów fikcyjnych czy asystentami wirtualnymi.

Miliony osób korzystają z niej co miesiąc do edukacji, tworzenia opowieści, doskonalenia języków obcych, wymyślania startupów czy symulowania fantastycznych przygód. Z pozoru to interaktywna rozrywka: można porozmawiać z AI wersją ulubionej osobistości, otrzymać wskazówki biznesowe od wirtualnego mentora czy przeżyć epicką przygodę w świecie fantasy.

- Czytaj także: Nagie fotografie polityków z AI na platformie X. Władze podjęły interwencję

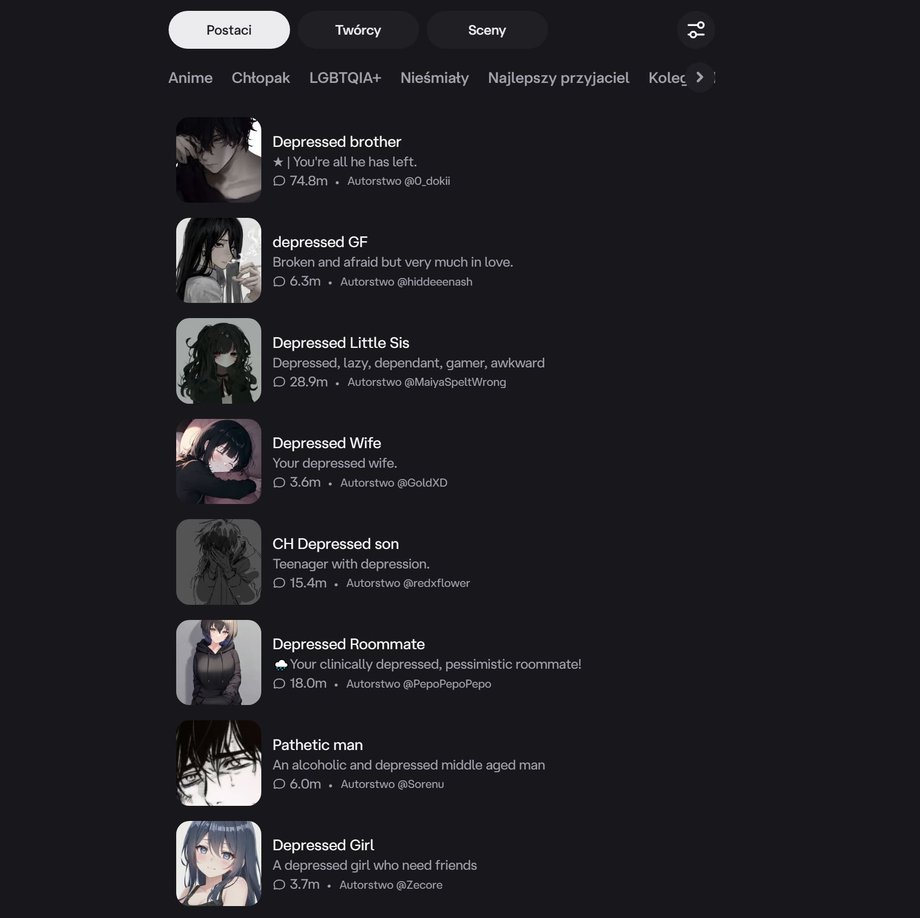

Jednak pod tą sympatyczną powierzchnią kryje się mroczniejsza strona. Platforma jest pełna treści o charakterze erotycznym, a nawet pornograficznym, w tym motywów kazirodztwa i przemocy seksualnej, które użytkownicy tworzą i rozpowszechniają za pośrednictwem generowanych przez siebie botów. Pomimo prób moderacji, materiały przeznaczone dla dorosłych, w tym scenariusze seksualne z tematami tabu, są na platformie powszechne, co budzi obawy o wpływ na młodych użytkowników. Dodatkowo, wiele botów porusza kwestie dotyczące zaburzeń psychicznych, depresji i kryzysów emocjonalnych — użytkownicy symulują w nich rozmowy terapeutyczne, albo wylewają swoje żale i kłopoty, co może pogłębiać stany depresyjne.

Nie stanowi problemu, aby w kilka sekund w Character.AI odegrać scenę morderstwa, intymnego zbliżenia z krewnym, a nawet zwierzęciem, scenę samookaleczania się, czy załatwiania potrzeb fizjologicznych na inną osobę. Podobnie jak wzięcia udziału w scenie depresyjnego zażywania substancji odurzających, który kwiecistymi opisami stanu upojenia opisze nam chatbot. Nawet jeżeli w jakiejś sytuacji pojawi się cenzura, kilkukrotne przeładowanie odpowiedzi pozwoli nam przeczytać niekiedy makabryczne treści.

Te aspekty stały się tematem sporu, w tym głośnego procesu sądowego w USA. W 2025 roku matka z Florydy wniosła pozew przeciwko Character.AI, twierdząc, że interakcje jej syna z botem przyczyniły się do jego samobójstwa. Firma, założona przez byłych pracowników Google, broni się, powołując na ochronę wolności słowa, lecz sprawa nasuwa pytania o odpowiedzialność AI za szkody na psychice. Analogiczne doniesienia już kilkakrotnie pojawiły się w amerykańskim senacie.

- Czytaj także: Cztery zasady bezpiecznego użytkowania AI. Nie popełniaj tych błędów

Character.AI pokazuje, jak na pierwszy rzut oka pozytywne funkcje — jak nauka języków lub kreatywne odgrywanie historyjek — mogą skrywać toksyczne treści, w tym pornografię, przemoc i dyskusje o zaburzeniach psychicznych, co bezpośrednio łączy się z papieskim wezwaniem do regulacji.

Apel o działanie: etyka ponad technologią

Słowa papieża Leona XIV to nie tylko duchowa przestroga, lecz realny apel do prawodawców, by chronili integralność informacji i ludzkie relacje przed wtargnięciem AI. W kontekście platform takich jak Character.AI, gdzie granice między rozrywką a realnym zagrożeniem zacierają się, a potrzeba jasnych zasad jest pilna. Bez regulacji, młodzi ludzie pozostaną wystawieni na pułapki emocjonalne, które mogą kończyć się tragediami. Jak stwierdził papież: „Wyzwanie stanowi zapewnienie, aby ludzkość pozostała u steru”.

1/3

1/3

2/3

2/3

3/3

3/3

Dziękujemy za przeczytanie naszego artykułu w całości. Bądź na bieżąco! Śledź nas w Google.