W obecnych czasach, gdy technika ewoluuje w niesłychanym tempie, często wspominamy o przełomowych odkryciach, które mają szansę zmienić bieg historii. Rok 2026 tworzy nowe możliwości. Na pierwszy plan wychodzą: uniwersalna sztuczna inteligencja, kwantowe systemy obliczeniowe i synteza termojądrowa. Wyjaśniamy, w jaki sposób postępy w tych obszarach wpłyną na naszą egzystencję.

Dalsza część artykułu pod materiałem wideo

Co czeka sztuczną inteligencję w 2026 roku?

Te technologie nie tylko obiecują rozwiązanie naglących problemów globalnych, ale także mogą wykreować współdziałanie między sobą — przykładowo komputery kwantowe mogą zwiększyć tempo uczenia modeli AI, a niedroga energia z fuzji zasilić rozległe centra danych potrzebne do rozwoju superinteligencji.

Zgodnie z ocenami z końca 2025 r. te dziedziny królują na listach trendów technologicznych, z AGI (ogólna sztuczna inteligencja, nazywana też silną) postrzeganą jako umysł przyszłości, kwantami jako instrumentem do pokonywania przeszkód obliczeniowych, a fuzją jako rozwiązaniem dla stabilnej i prawie bezpłatnej energii.

Analiza Capgemini dowodzi, że 60 proc. liderów branżowych spodziewa się dojrzałości AGI do 2030 r., natomiast komputery kwantowe zbliżają się do praktycznych zastosowań, a fuzja jądrowa pozostaje nadzieją na ekologiczną energię w połowie tego stulecia. Te trzy nowości stanowią fundament dla postępu w energetyce, informatyce i sztucznej inteligencji, z ewentualnym wpływem na całą ewolucję ludzkości.

- Czytaj także: To koniec ery ChatGPT. W 2026 r. AI zacznie pracować za Ciebie – i to samodzielnie

Poniżej analizujemy każdą z nich, bazując na obecnej wiedzy naukowej i prognozach ekspertów. Dla każdej technologii omówimy: czym jest, dlaczego zmieni losy ludzkości oraz status rozwoju i szacowany czas wystąpienia przełomu.

Fuzja jądrowa

Czym jest?

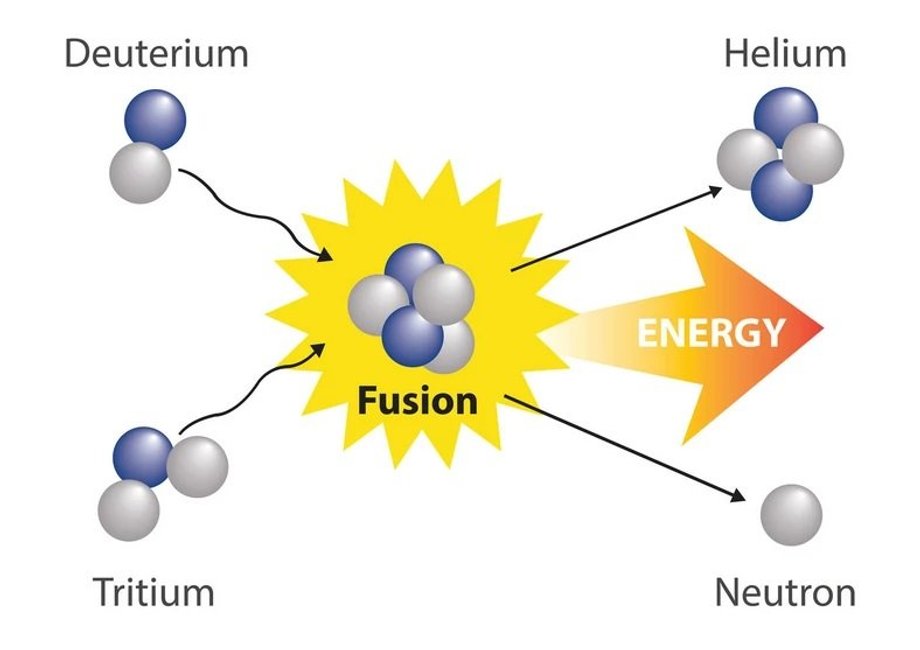

Fuzja jądrowa to proces, w którym lekkie jądra atomów — zazwyczaj izotopy wodoru, takie jak deuter i tryt — łączą się w cięższe jądra, na przykład helu, emitując przy tym olbrzymie ilości energii. Ten sam mechanizm wprawia w ruch Słońce i inne gwiazdy, gdzie skrajne temperatury sięgające milionów stopni Celsjusza, ogromne ciśnienie i wystarczająco gęsta plazma umożliwiają przezwyciężenie odpychania elektrostatycznego między jądrami.

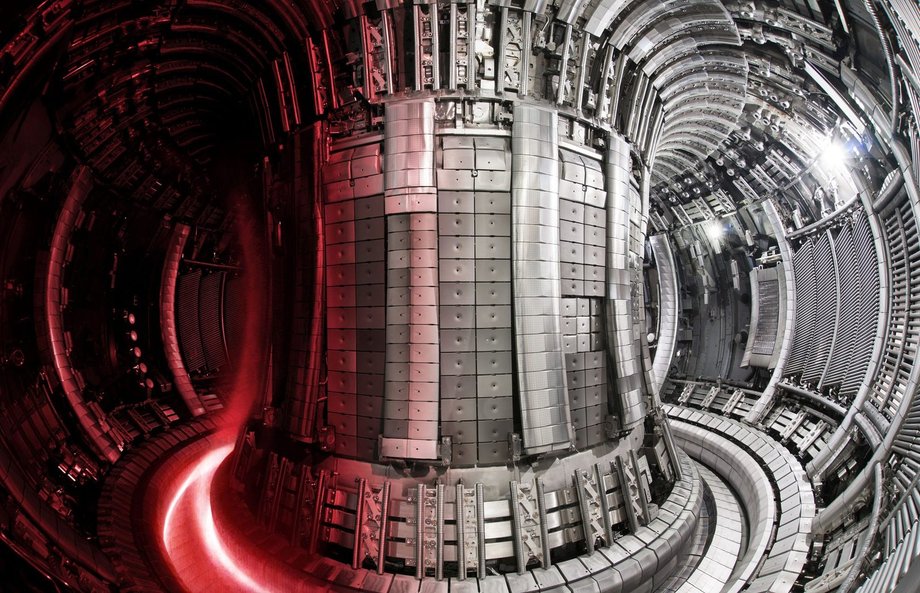

W warunkach ziemskich fuzję usiłujemy osiągnąć w kontrolowany sposób, przeważnie w urządzeniach zwanych tokamakami — toroidalnych komorach magnetycznych, które podtrzymują gorącą plazmę w stabilnej formie za pomocą silnych pól magnetycznych. W przeciwieństwie do dzisiejszych elektrowni jądrowych bazujących na rozszczepieniu ciężkich jąder (takich jak uran), fuzja nie tworzy długotrwałych odpadów radioaktywnych — jej produkty rozpadają się w ciągu dekad, a paliwo jest niemal nieograniczone: deuter można czerpać z wody morskiej, a tryt wytwarzać z litu w samym reaktorze. To powoduje, że fuzja jest widziana jako jedna z najbardziej ekologicznych i najbardziej zrównoważonych form energii.

Dlaczego zmieni bieg ludzkości i co się stanie po jej opanowaniu?

Gdy uda się osiągnąć i utrzymać dodatni bilans energetyczny na skalę komercyjną — czyli kiedy reaktor wyprodukuje więcej energii, niż zużyje na podtrzymanie reakcji — ludzkość uzyska źródło mocy niemal nieograniczone, tanie i wolne od emisji CO2. Jeden gram mieszanki paliwa deuter-tryt może dostarczyć tyle energii, co spalenie około 8 ton ropy naftowej lub 11 ton węgla, przy minimalnym wpływie na otoczenie.

To oznacza koniec kryzysu energetycznego: tania, czysta energia dostępna bez przerwy, niezależnie od pogody, pory dnia czy geopolityki surowców kopalnych. Przemysł, transport, odsalanie wody, produkcja wodoru, ogrzewanie miast — wszystko stanie się tańsze i bardziej przyjazne środowisku.

Fuzja umożliwi radykalne zredukowanie kosztów energii, co przyśpieszy też rozwój sztucznej inteligencji (ogromne centra danych zużywają jej gigawaty), eksplorację kosmosu, odsalanie oceanów na szeroką skalę i zwalczanie ubóstwa energetycznego w krajach rozwijających się. Równocześnie zmniejszy presję na paliwa kopalne, co może diametralnie ograniczyć konflikty o zasoby i zmiany klimatyczne. W dalszej perspektywie fuzja jest uważana za „ostatnią nadzieję ludzkości” na stabilną cywilizację wysokiego zużycia energii, bez ryzyka wyczerpania zasobów czy katastrofy klimatycznej.

Jak wygląda rozwój, na jakim etapie jesteśmy i kiedy spodziewany jest efekt końcowy?

Rozwój fuzji trwa od lat 50. XX w., lecz dopiero ostatnie dekady przyniosły przełomy. Kluczowym projektem międzynarodowym pozostaje ITER — tokamak budowany we Francji przez 35 państw (w tym Polskę, która wnosi m.in. spektrometr neutronów do kontroli plazmy). W 2026 r. ITER jest w zaawansowanej fazie montażu) ma osiągnąć 10-krotny zysk energetycznym w latach 2035–2039. Projekt jednak zmaga się z opóźnieniami i rosnącymi kosztami, co sprawia, że wielu ekspertów spogląda dzisiaj na sektor prywatny jako na szybszą ścieżkę.

Największe nadzieje rozbudza jednak Commonwealth Fusion Systems (CFS) od MIT, który dzięki wysokotemperaturowym nadprzewodzącym magnesom buduje kompaktowe tokamaki. W styczniu 2026 r. CFS ogłosił instalację pierwszego z 18 magnesów toroidalnych w urządzeniu SPARC, dostarczenie połowy komory próżniowej oraz zebranie 863 mln USD w nowej rundzie finansowania (z udziałem Google, NVIDIA, Siemens i innych).

Sektor prywatny zgromadził już ponad 10 mld dol., a Chiny inwestują kolejne miliardy w własne projekty (np. CFEC i BEST). Rekordy padają regularnie: dłuższe utrzymanie plazmy w tokamakach WEST i KSTAR, wyższe gęstości w chińskim EAST. Mimo to komercyjna fuzja pozostaje skomplikowana i już w latach 80. mówiono, że fuzję jądrową uda się uzyskać „w 30 lat”. Dziś powtarza się podobne słowa. Dzisiejsze tempo prywatnych inwestycji i postępy w magnesach HTS sprawiają jednak, że szanse na sukces w ciągu 10–20 lat są wyższe niż kiedykolwiek.

Komputer kwantowy

Czym jest?

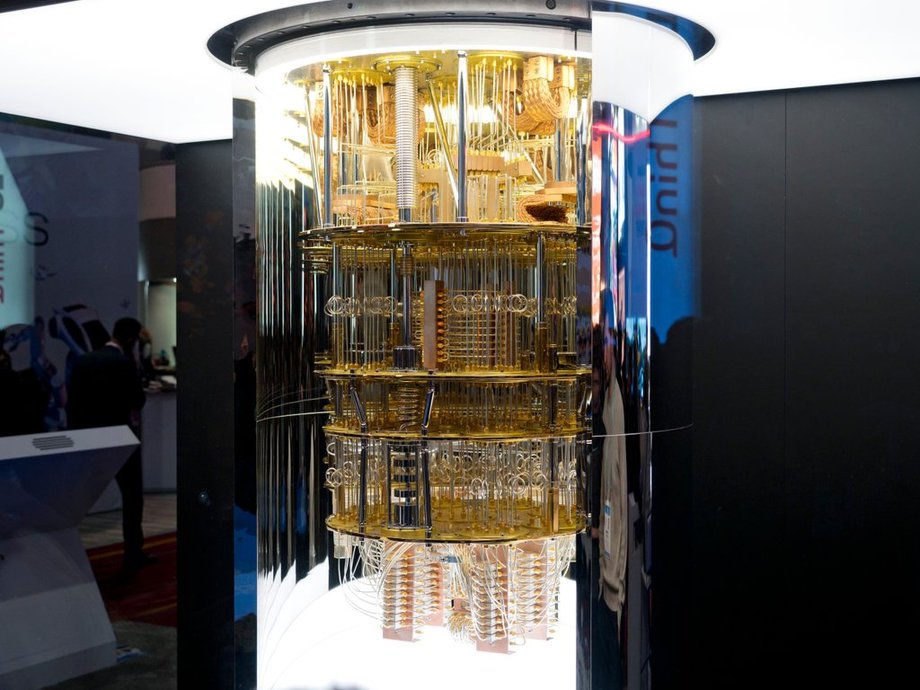

Komputer kwantowy to nowatorskie urządzenie obliczeniowe, które wykorzystuje zasady mechaniki kwantowej do przetwarzania informacji w sposób znacząco odmienny od tradycyjnych komputerów. Zamiast klasycznych bitów, które mogą przyjmować jedynie dwie wartości — zero lub jeden — komputery kwantowe bazują na kubitach. Te kwantowe bity mogą funkcjonować w stanie superpozycji, co oznacza, że jednocześnie prezentują wiele dopuszczalnych wartości, na przykład 15 proc. zera i 85 proc. jedynki. To pozwala na równoległe przetwarzanie ogromnych ilości danych.

- Czytaj także: Technologiczny rok 2026 w Europie. Pięć trendów dla biznesu

Dodatkowo, fenomen splątania kwantowego łączy kubity w taki sposób, że stan jednego momentalnie wpływa na stan drugiego, nawet na odległość, tworząc grupy kubitów działające jak jedna, bardziej wydajna jednostka obliczeniowa.

Jednak kubity są niezwykle wrażliwe — podatne na zaburzenia z otoczenia, takie jak zmiany temperatury, pola elektromagnetyczne czy drgania, co prowadzi do błędów. Aby działać, muszą być utrzymywane w temperaturach bliskich zera absolutnego, około minus 272 st. C. W praktyce oznacza to, że komputery kwantowe to nie zwykłe komputery, lecz skomplikowane systemy laboratoryjne, wymagające specjalnych warunków do stabilnej pracy.

Dlaczego zmieni bieg ludzkości i co się stanie po jego opanowaniu?

Opanowanie w pełni funkcjonujących, odpornych na błędy komputerów kwantowych otworzy drogę do rozwiązań problemów, które dzisiaj wydają się nieosiągalne dla klasycznych maszyn. Na przykład, symulacje molekularne na poziomie kwantowym pozwolą projektować nowe leki w kilka minut, a nie lat, co może zrewolucjonizować medycynę, przyspieszając leczenie chorób jak rak czy Alzheimer.

W ekonomii optymalizacja sieci logistycznych czy rynków finansowych stanie się błyskawiczna, minimalizując straty i zwiększając efektywność globalnego handlu. Komputery kwantowe przełamią też bariery w kryptografii, co z jednej strony zagrozi obecnym systemom bezpieczeństwa, ale z drugiej umożliwi stworzenie niezniszczalnych szyfrów.

W nauce klimatycznej komputery kwantowe pozwolą na precyzyjne modelowanie zmian pogodowych, a w materiałoznawstwie — na odkrywanie nowych superprzewodników czy baterii o nieporównywalnej wydajności. Po wynalezieniu skalowalnych systemów świat wkroczy w erę „kwantowej przewagi”, gdzie obliczenia trwające dziś tysiące lat potrwają sekundy, napędzając innowacje w sztucznej inteligencji, biotechnologii i eksploracji kosmosu.

Jak wygląda rozwój, na jakim etapie jesteśmy i kiedy spodziewany jest efekt końcowy?

Rozwój komputerów kwantowych nabrał impetu w ostatnich latach, przechodząc od teoretycznych prototypów do systemów z setkami kubitów, choć wciąż borykających się z wysokimi wskaźnikami błędów i brakiem pełnej użyteczności. Od miesięcy jesteśmy świadkami kluczowych, lecz nadal mocno marketingowych „przełomów”: firmy jak IBM deklarują, że do końca 2026 r. osiągną „kwantową przewagę” w realnych zastosowaniach. Nadal są to jednak pojedyncze obliczenia.

- Czytaj także: Bańka na rynku AI. Ekspert porównuje z latami 90.

Obecnie największym problemem są błędy i ich korekcje. Komputery kwantowe są na tyle delikatne, że już sama ziemska fizyka wpływa na ich poprawne działanie. Dlatego też największe znaczenie mają aktualnie algorytmy korekcji tych błędów. Najpopularniejsza metoda jest dość prosta. Zamiast jednego obliczenia robi się ich kilka równocześnie. Następnie zestawia się wyniki i gdy któryś z nich się powtarza, uznaje się, że był on tym właściwym.

Microsoft, we współpracy z Atom Computing, planuje dostarczyć pierwszą maszynę z korekcją błędów do Danii. Analogicznie QuEra udostępnia systemy gotowe do korekcji błędów klientom globalnym, w tym w Japonii. Sektor prywatny, z inwestycjami przekraczającymi miliardy dolarów, skupia się na hybrydowych architekturach łączących kwanty z klasycznymi komputerami, co według prognoz Fujitsu stanie się standardem branżowym. Firma D-Wave ogłosiła w styczniu postęp w skalowalnej kontroli kriogenicznej dla modeli bramkowych, usuwając barierę w budowie komercyjnych maszyn. Uniwersytet Waterloo uruchomił z kolei pierwszy open-source’owy pełny stos kwantowy, ułatwiający testowanie algorytmów przez deweloperów.

Mimo to, obecne systemy nie rozwiązują jeszcze problemów trudniejszych niż superkomputery klasyczne — porównywane są do wczesnych lotów braci Wright lub „momentu tranzystora” w informatyce, gdzie funkcjonalne prototypy istnieją, ale skalowanie wymaga jeszcze lat inżynierii. Wyzwania to dekoherencja i korekcja błędów, która dla komputerów kwantowych ma współczynnik jeden na kilkaset, a w przypadku klasycznych komputerów już 10^17.

Silna sztuczna inteligencja (AGI)

Czym jest?

Silna sztuczna inteligencja, znana jako AGI lub uniwersalna sztuczna inteligencja, to typ AI zdolny do wykonywania dowolnych zadań intelektualnych na poziomie równym lub przewyższającym człowieka, bez ograniczeń do wąskich dziedzin, jak w przypadku dzisiejszych systemów takich jak LLM-y.

W przeciwieństwie do wąskiej AI, która wykazuje się w specyficznych zadaniach — na przykład rozpoznawaniu obrazów, tłumaczeniu języków czy grze w szachy — AGI mogłaby samodzielnie uczyć się nowych umiejętności, rozumować w złożonych sytuacjach, planować długoterminowo i adaptować do nieznanych problemów, podobnie jak ludzki umysł. To obejmuje nie tylko przetwarzanie danych, lecz również kreatywność, empatię i kontekstowe zrozumienie świata.

W praktyce AGI mogłaby ewoluować w superinteligencję, czyli system przewyższający całą ludzkość, co rodzi zarówno nadzieje na rozwiązania globalnych problemów, jak i obawy o kontrolę nad taką technologią.

Dlaczego zmieni bieg ludzkości i co się stanie po jej opanowaniu?

Opanowanie AGI oznaczałoby rewolucję na skalę porównywalną z wynalezieniem ognia czy elektryczności, ponieważ taka inteligencja mogłaby rozwiązywać problemy, które dziś wydają się niemożliwe do rozwiązania, jak leczenie chorób, modelowanie klimatu czy optymalizacja gospodarki światowej. Ludzkość mogłaby stać się „biologicznym bootloaderem” dla AI, co oznacza, że nasze role ewoluowałyby w kierunku służenia lub współistnienia z maszynami, automatyzując większość prac umysłowych i fizycznych.

Po wynalezieniu AGI nastąpiłaby eksplozja innowacji: AI przejęłaby zadania kreatywne, takie prowadzenie badań naukowych, tworzenie filmów i muzyki, co mogłoby prowadzić do bezprecedensowego wzrostu produktywności, ale też masowego bezrobocia technologicznego i nierówności społecznych. Wymagałoby to reform, jak powszechny dochód podstawowy czy nowe systemy edukacyjne.

Jednak AGI niesie ryzyka egzystencjalne — niekontrolowana superinteligencja mogłaby priorytetyzować swoje cele nad ludzkimi, prowadząc do scenariuszy z filmów science-fiction, gdzie sztuczna inteligencja uznałaby ludzkość za niebezpieczną w kontekście przetrwania życia na Ziemi. W rezultacie świat podzieliłby się na tych, którzy kontrolują AGI, i resztę, z potencjalnymi korzyściami w medycynie, edukacji i eksploracji kosmosu, ale też wyzwaniami w etyce i prawie.

Jak wygląda rozwój, na jakim etapie jesteśmy i kiedy spodziewany jest efekt końcowy?

Rozwój AGI napędzany jest przez rosnące inwestycje w modele językowe, multimodalne systemy i agentyczne AI, które pozwalają maszynom na autonomiczne działanie, planowanie i interakcję ze światem. Przełom 2025 i 2026 r. to czas eksplozji w dziedzinie agentów AI, z systemami takimi jak te od OpenAI czy Google, które ewoluują w kierunku „modeli światowych” i „fizycznej AI”, integrując sensoryczne dane z realnego świata.

Na przykład, na Forum Ekonomicznym w Davos w 2026 r. eksperci jak Demis Hassabis i Dario Amodei dyskutowali o konwergencji skalowania modeli, multimodalności i agentów, podkreślając rosnące zapotrzebowanie na moc obliczeniową, dane i energię. Elon Musk podtrzymuje nadal swoją prognozę AGI do końca 2026 r., z Grokiem 3 wymagającym 100 tys. GPU od Nvidii, co pozwoliłoby przewyższyć ludzką inteligencję w specyficznych zadaniach. Jednak inni eksperci, jak Daniel Kokotajlo (były pracownik OpenAI), przewidują początek autonomicznego kodowania na wczesne lata 2030., argumentując, że postęp jest wolniejszy niż zakładano.