Biznes Fakty

Wyszukiwarki AI często wprowadzają w błąd. Grok Elona Muska jest najgorszy

Od kilku lat sztuczna inteligencja wzbudza znaczny entuzjazm, jednak coraz głośniej słychać sceptycyzm co do wiarygodności i niezawodności narzędzi opartych na modelach językowych. Ostatnie ustalenia Tow Center for Digital Journalism ujawniają, że wyszukiwarki AI nie tylko nie zapewniają dokładności wyników, ale także wprowadzają użytkowników w błąd, a dzieje się tak w ponad połowie przypadków.

- Podsumowując, wyszukiwarki oparte na sztucznej inteligencji są zawodne

- Z punktu widzenia biznesu stanowi to spore wyzwanie, gdyż sygnalizuje realne ryzyko dla firm, które polegają na niezawodnych narzędziach do przetwarzania danych i wyszukiwania informacji.

- Niezależnie od tego, czy jest to ChatGPT Search, Perplexity czy DeepSeek, wyniki są rozczarowujące

- Największe nieścisłości zauważono w przypadku Groka stworzonego przez Elona Muska – jest on błędny w ponad 90 proc. przypadków

- Dodatkowe informacje dotyczące biznesu znajdziesz na stronie Businessinsider.com.pl

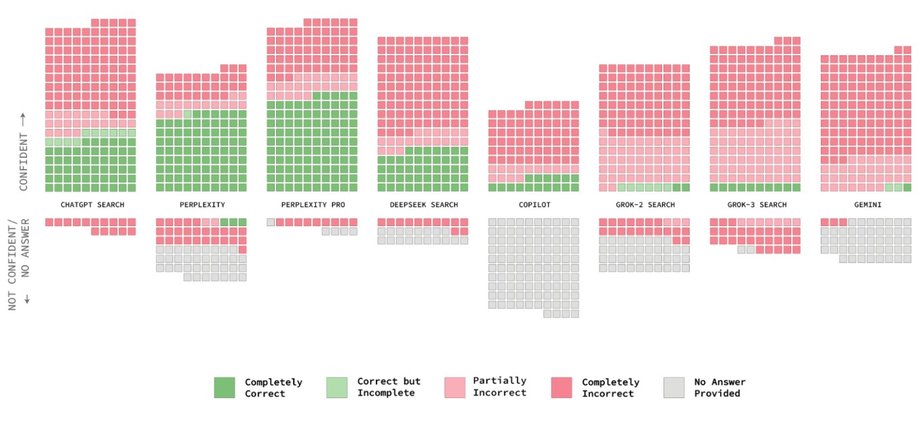

Aisvarya Chandrasekar i Klaudia Jaźwińska, autorki raportu z Tow Center for Digital Journalism, przeanalizowały osiem zaawansowanych narzędzi, w tym ChatGPT Search, Perplexity, Perplexity Pro, Gemini, DeepSeek Search, Grok-2, Grok-3 i Copilot. Poddały każde z nich prostemu testowi, aby ustalić , czy sztuczna inteligencja może dokładnie zidentyfikować komunikat prasowy na podstawie krótkiego cytatu.

Ocena koncentrowała się na tym, czy chatbot poprawnie wskazał tytuł, wydawcę i adres URL. Wyniki? Były rozczarowujące. Po zebraniu danych z 200 artykułów z 20 różnych źródeł stało się oczywiste, że ogólny wskaźnik błędów przekroczył 60 procent. W obszarze wyszukiwania, który teoretycznie jest podstawową funkcją sztucznej inteligencji, jest to niepokojący wynik.

Sprawdź także: Skomplikowane przepisy i umowy wypełnione zawiłymi terminami? Przekaż to AI i nie daj się wykorzystać

Wyszukiwarki oparte na sztucznej inteligencji nie są niezawodne

Problem wykracza poza niezdolność SI do udzielenia wiarygodnej odpowiedzi. Jeszcze bardziej niepokojące jest zjawisko znane jako halucynacja, w którym algorytm przedstawia nieprawidłowe wnioski z całkowitą pewnością, a po złapaniu rozbieżności może nadal generować więcej sfabrykowanych treści.

Oznacza to, że odpowiedzi często wydają się bardzo profesjonalne, ale brakuje im podstaw faktycznych . Ta nieuzasadniona pewność siebie może łatwo wprowadzić użytkowników w błąd, szczególnie gdy ufają reputacji marki stojącej za narzędziem AI i nie sprawdzają informacji z innych źródeł.

Warto zauważyć, że nawet modele premium, które są rzekomo bardziej zaawansowane, nie działają dużo lepiej. Usługi, które kosztują kilkadziesiąt dolarów miesięcznie, nie zapewniają większej dokładności i często generują jeszcze więcej błędów , odwołując się do nieistniejących linków lub niepoprawnie przypisując autorstwo zupełnie innym redaktorom.

Z perspektywy biznesowej niepokojące jest również to, że nieumyślnie szkodzi to reputacji wydawców, których teksty są nieprawidłowo przypisywane przez sztuczną inteligencję lub w ogóle nie są powiązane ze źródłem. W związku z tym niektórzy wydawcy zdecydowali się całkowicie zablokować dostęp do botów indeksujących, mając na celu zachowanie kontroli nad własną treścią. Tutaj również pojawiły się paradoksalne sytuacje : niektóre narzędzia nadal publikują streszczenia wybranych artykułów, ignorując życzenia pierwotnych właścicieli artykułów.

Przeczytaj także: AI otwiera drogę do zakładania startupów bez konieczności pisania kodu. Koszty tworzenia nie są już przeszkodą

Technologia jest niezwykła. Jakość jest słaba

Badania wskazują, że sama technologia, choć imponująca pod względem szybkości i płynności, często pozostaje zawodna. Wyszukiwarki AI mogą bez wahania udzielać odpowiedzi politycznych lub specjalistycznych, a następnie przyznawać się do błędu i… wkrótce potem ponownie przedstawiać sfabrykowane fakty. Takie manipulacje, celowe lub nie, mogą

Źródło